Un empleado de OpenAI descubre el efecto Eliza y se emociona

La nueva función de texto a voz de ChatGPT hace que un jefe de sistemas de seguridad de OpenAI se sienta “escuchado y cálido”, mientras que otros experimentos con terapia de IA lo han logrado. sido un desastre.

Diseñar un programa de tal manera que realmente pueda convencer a alguien de que otro ser humano está al otro lado de la pantalla tiene ha sido un objetivo de los desarrolladores de IA desde que el concepto dio sus primeros pasos hacia la realidad. La empresa de investigación OpenAI anunció recientemente que su producto estrella ChatGPT obtendría ojos, oídos y voz en su búsqueda por parecer más humana. Ahora, una ingeniera de seguridad de IA en OpenAI dice que se puso “bastante emocional” después de usar el chatbot. modo de voz para tener una sesión de terapia improvisada.

“Acabo de tener una conversación personal y bastante emotiva con ChatGPT en modo de voz, hablando sobre el estrés y el equilibrio entre el trabajo y la vida personal”, dijo el director de OpenAI. sistemas de seguridad Lilian Weng en un tweet al corriente ayer. “Curiosamente, me sentí escuchado y cálido. Nunca había probado la terapia antes, pero ¿probablemente sea esto? Pruébela, especialmente si generalmente solo Úsalo como una herramienta de productividad”.

La experiencia de Weng como empleado de OpenAI promocionando los beneficios de un producto OpenAI obviamente debe tomarse con cautela, pero Habla de los últimos intentos de Silicon Valley de forzar la IA a proliferar en cada rincón de nuestras vidas plebeyas. También habla a la sensación de que todo lo viejo es nuevo de nuevo en este momento del auge de la IA.

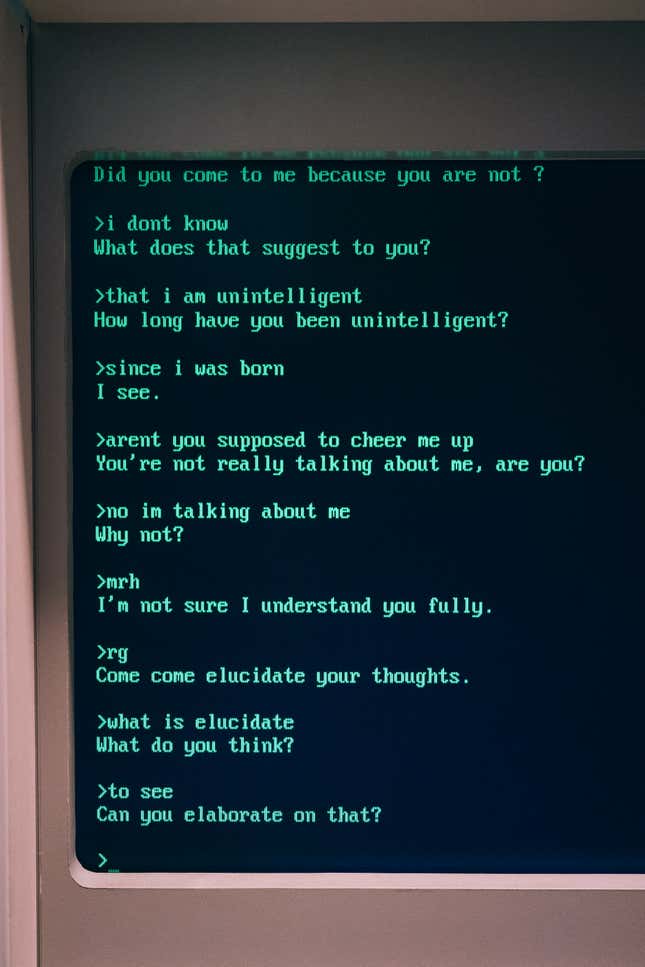

El optimismo tecnológico de la década de 1960 generó algunos de los primeros experimentos con “IA”, que se manifestaron como ensayos para imitar los procesos de pensamiento humano. usando una computadora. Una de esas ideas fue un programa de computación de procesamiento del lenguaje natural conocido como elisa, desarrollado por Joseph Weizenbaum del Instituto de Tecnología de Massachusetts.

Eliza elaboró un guión llamado Doctor que fue modelado como parodia del psicoterapeuta Carl Rogers. En lugar de sentirse estigmatizada y sentarse en una congestionada oficina de psiquiatra, la gente podría sentarse en una terminal de computadora igualmente congestionada para recibir ayuda con sus problemas más profundos. Excepto que Eliza no era tan inteligente y el guión simplemente se aferraría a ciertas palabras y frases clave y, esencialmente, reflejarlas al usuario de una manera increíblemente simplista, muy como lo haría Carl Rogers. En un giro extraño, Weizenbaum comenzó notar que los usuarios de Eliza se estaban apegando emocionalmente a las salidas rudimentarias del programa; se podría decir que se sintieron “escuchados y cálidos” Utilice las propias palabras de Weng.

“Lo que no me había dado cuenta es que las exposiciones extremadamente breves a un programa de computadora relativamente simple podrían inducir pensamientos delirantes poderosos en personas bastante normales. ”, Weizenbaum escribió más tarde en su libro de 1976. El poder de la computadora y la razón humana.

Decir que las pruebas más recientes en terapia de IA también se han estrellado y quemado sería decirlo a la ligera. Salud mental entre pares aplicación Koko decidió experimentar con una inteligencia artificial haciéndose pasar por consejera para 4.000 de los usuarios de la plataforma. El cofundador de la empresa, Rob Morris, le dijo a Gizmodo a principios de este año que “este será el futuro”. .” Los usuarios en el rol de consejeros podrían generar respuestas utilizando Koko Bot, una aplicación de ChatGPT3 de OpenAI, que luego podría editarse, enviarse y enviarse. o rechazados por completo. Según se informa, se crearon 30.000 mensajes utilizando la herramienta, que recibió respuestas positivas, pero Koko desconectó porque el chatbot sintió estéril. Cuando Morris compartió su experiencia en Twitter (ahora conocido como X), la reacción pública fue insuperable.

En el lado más oscuro de las cosas, a principios de este año, un hombre belga viuda dijo su marido Murió por suicidio después de quedar absorto en conversaciones con una IA que lo animó a suicidarse.

En mayo pasado, la Asociación Nacional de Trastornos de la Alimentación tomó la audaz medida de disolver su línea directa para trastornos de la alimentación, a la que quienes estaban en crisis podían llamar. en busca de ayuda. En su lugar, NEDA optó por reemplazar el personal de la línea directa con un chatbot llamado Tessa. El despido masivo ocurrió solo cuatro días después de que los empleados se sindicalizaran, y antes de esto, el personal supuestamente se sentía sin recursos y con exceso de trabajo, lo cual es especialmente discordante cuando se trabaja tan estrechamente con una población en riesgo. Después de menos de una semana de usar Tessa, NEDA cerradaered el chatbot. Según a correo En la página de Instagram de la organización sin fines de lucro, Tessa “puede haber brindado información que fue dañina y no relacionada con el programa”.

En resumen, si nunca has ido a terapia y estás pensando en probar un chatbot como alternativa, no lo hagas.

Este contenido ha sido traducido automáticamente del material original. Debido a los matices de la traducción automática, pueden existir ligeras diferencias. Para la versión original, haga clic aquí.